Comment entraîne-t-on les algorithmes lorsque des vies humaines sont en jeu ? Au sein de Thales, plus de 600 experts développent une intelligence artificielle pour les domaines de défense et de sécurité, avec des contraintes sans commune mesure avec l’IA grand public.

« Cet environnement critique nous amène des devoirs qui n’existent pas dans un environnement grand public. La contrainte est injectée dès la conception de l’algorithme d’IA qui ne peut pas fonctionner comme une boîte noire et où l’humain est absolument essentiel », explique à l’AFP Philippe Keryer, directeur stratégie, recherche et technologies de Thales, premier détenteur de brevets en IA des systèmes critiques en Europe.

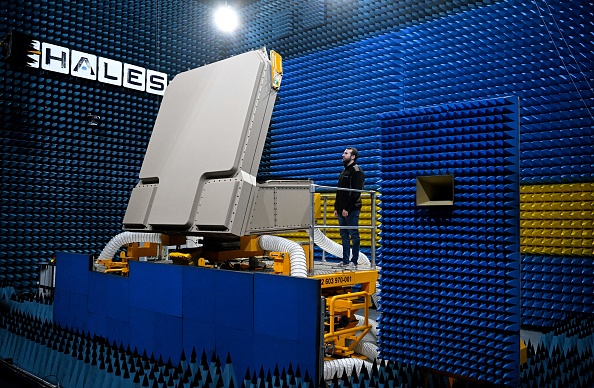

Système de lutte anti-drones aériens éprouvé pendant les Jeux olympiques à Paris, capteurs intelligents pour détecter les mines sous-marines, pilotage d’essaims de drones, optimisation des trajectoires de vol ou prévention de la fraude d’identité : en amont du Sommet pour l’action sur l’IA, qui se tiendra à Paris les 10 et 11 février, Thales a ouvert cette semaine ses laboratoires de recherche à Palaiseau, en région parisienne.

Thales équipe 50 armées dans le monde

L’impact de ces innovations est « énorme pour les enjeux de sécurité, de souveraineté et d’efficacité énergétique », souligne Patrice Caine, PDG de Thales, qui équipe 50 armées dans le monde et dont les systèmes gèrent 40% de l’espace aérien mondial.

« Nous avons la responsabilité de repenser en profondeur le fonctionnement de l’IA ainsi que des modèles d’apprentissage », relève Philippe Keryer.

Des « hackers éthiques » pour anticiper les menaces

Le nombre des données dans ces domaines sensibles étant limité, le groupe génère sur la base de son expertise des données synthétiques pour entraîner ses algorithmes.

Il emploie des « hackers éthiques » pour anticiper les menaces, inventer les attaques les plus sophistiquées et soumettre les logiciels à un « crash test de résilience » avant d’être validés.

Un principe « du glaive et du bouclier » déjà appliqué pour les systèmes d’armement (drones et systèmes anti-drones). « C’est en pensant au mal avec les attaques les plus perfides qu’on va créer le bien », affirme Philippe Keryer.

« On réapprend instantanément à l’IA à être plus pertinente »

Autre défi : sur un champ de bataille, « on est contraint en taille, en poids, en puissance, mais aussi par le type de réseau auquel on est connecté », signale Fabien Flacher, responsable de la cybersécurité au sein de Thales.

Sur une frégate, dans un Rafale ou un tank, on ne dispose pas de « fermes de serveurs » comme Google, ajoute-t-il.

Et si les intelligences artificielles sont généralement entraînées sur des données « figées longtemps », cela ne peut pas marcher pour les conflits modernes.

« On réapprend instantanément à l’IA à être plus pertinente » après chaque mission, par exemple d’un avion de reconnaissance où elle est intégrée.

La décision cruciale revient toujours à l’humain

« On juge les IA plus sévèrement que les humains », estime Christophe Meyer, directeur technique de CortAIx Labs, chargé de l’IA pour Thales.

Mais la décision cruciale revient toujours à l’humain. « S’il y a des drones avec des capacités de tirer, il y aurait une décision humaine pour dire ‘Je valide cette suggestion que tu me fais, avec mes critères qui sont des critères humains' », note-t-il.

Les solutions proposées par ce type d’IA contiennent également une explication rationnelle. Les calculs qu’elle fournit permettent à l’opérateur de soulager sa charge cognitive et parfois de rester moins de temps dans une zone où sa vie est en danger.

Ainsi, un radar intelligent « va reconnaître la dimension de centaines de cibles en quelques dizaines de secondes, là où il nous fallait des dizaines de minutes auparavant », précise Nicolas Léger, expert radars à Thales.

Seulement « 1% à 2% » de fausses alarmes

Pareil dans la lutte contre les mines: les antennes qui détectent les engins suspects sont de plus en plus performantes, mais produisent une quantité de données impossible à digérer pour un humain.

Les algorithmes aident à « accélérer la classification et évaluer la pertinence de produire des opérations d’identification et de neutralisation », explique Benoît Drier de Laforte, conseiller dans la lutte anti-mines. Cette technique permet d’avoir seulement « 1% à 2% » de fausses alarmes, quand « les Américains se contentaient de 20% de marge d’erreur sur certaines opérations » de ce type, selon lui.

Pourtant les algorithmes ne sont pas encore prêts à remplacer « les grandes oreilles » humaines. « Si l’algorithme n’a pas été entraîné sur une menace nouvelle, il risque de manquer de performance », signale l’expert.

Comment pouvez-vous nous aider à vous tenir informés ?

Epoch Times est un média libre et indépendant, ne recevant aucune aide publique et n’appartenant à aucun parti politique ou groupe financier. Depuis notre création, nous faisons face à des attaques déloyales pour faire taire nos informations portant notamment sur les questions de droits de l'homme en Chine. C'est pourquoi, nous comptons sur votre soutien pour défendre notre journalisme indépendant et pour continuer, grâce à vous, à faire connaître la vérité.